KI Neuigkeiten

18 Jan. 2026

Read 8 min

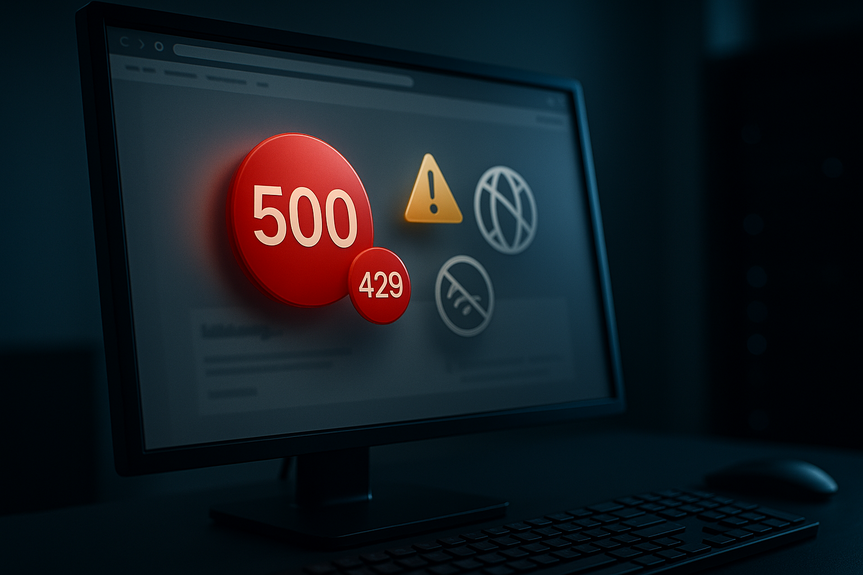

HTTP 429 zu viele Anfragen beheben: 5 schnelle Lösungen

HTTP 429 zu viele Anfragen beheben gelingt mit Drosselung, Retry-After, Caching, Quoten und Queues.

HTTP 429 zu viele Anfragen beheben: 5 schnelle Lösungen

1) Anfragen drosseln und Retry-After respektieren

Der wichtigste Schritt ist weniger Tempo: – Lies den Retry-After-Header und warte so lange, wie der Server vorgibt. – Nutze exponentielles Backoff: Wartezeiten z. B. 1s, 2s, 4s, 8s, bis eine Obergrenze. – Begrenze parallele Verbindungen. Starte mit wenigen gleichzeitigen Requests und erhöhe langsam. – Plane Pausen in Schleifen ein (sleep) und verteile Last über die Zeit. Mit dieser Disziplin kannst du HTTP 429 zu viele Anfragen beheben, ohne größere Umbauten. Du passt nur das Timing an die Regeln des Zielsystems an.2) Caching und Request-Batching nutzen

Wiederholte Abfragen auf die gleichen Daten verursachen unnötige Last. Reduziere sie: – Cache GET-Antworten für einen sinnvollen Zeitraum. – Nutze bedingte Abrufe (z. B. nur aktualisieren, wenn sich Daten geändert haben). – Bündle mehrere kleine Abfragen zu einer größeren, wenn API und Use Case das erlauben. – Paginierung sauber einsetzen und nicht Seiten mehrfach laden. So sinkt die Request-Anzahl deutlich und der Fehler tritt seltener auf.3) Quoten, Limits und API-Keys prüfen

Viele APIs haben Tages-, Minuten- oder Burst-Limits: – Prüfe dein Kontingent und hebe den Plan an, wenn du es regelmäßig sprengst. – Vermeide geteilte API-Keys über mehrere Services oder Teams. – Baue interne Kontingent-Checks ein, die bei 80–90 % der Quote frühzeitig bremsen. – Protokolliere Limits und Fehlerschwellen transparent. Wer seine Limits kennt und aktiv steuert, kann HTTP 429 zu viele Anfragen beheben, bevor Nutzer es merken.4) Warteschlangen und Rate Limiter einführen

Eine Queue verhindert Lastspitzen: – Stelle eingehende Aufträge in eine Warteschlange. – Verarbeite sie mit konstanter Geschwindigkeit (Worker mit fixer Rate). – Setze Rate Limiter (z. B. Token Bucket) vor externe Calls. – Priorisiere wichtige Vorgänge und verschiebe Unkritisches. So glättest du Peaks und hältst dich automatisch unter den Limits.5) Infrastruktur und IP-Hygiene verbessern

Technische Stolpersteine lösen ebenfalls 429 aus: – Prüfe, ob ein Bot oder Cronjob zu aggressiv läuft. – Vermeide unnötige Parallelität in Jobs und Microservices. – Nutze eine stabile, dedizierte IP, wenn geteilte IPs Probleme machen. – Passe Firewall-, WAF- oder CDN-Regeln an, falls legitime Anfragen blockiert werden. – Kontaktiere den Anbieter, wenn du Whitelists oder klarere Limits brauchst.Ursachen erkennen und schneller debuggen

Typische Anzeichen

– Der Fehler tritt in Peaks auf (z. B. zur vollen Stunde). – Bestimmte Endpunkte sind häufiger betroffen. – Logs zeigen kurze Abstände zwischen identischen Anfragen. – Der Server sendet einen Retry-After-Header mit Sekunden- oder Datumsangabe.Client- oder Serverseite?

– Clientseitig: Zu viele oder zu schnelle Requests, fehlendes Caching, kein Backoff. – Serverseitig: Sehr strenge Limits, zu niedrige Schwellen, falsch konfigurierte Schutzregeln.Praxis-Tipps für verschiedene Szenarien

Web-Scraper und Bots

– Beachte robots.txt und setze eine Crawl-Delay, falls vorhanden. – Randomisiere Pausen, aber halte dich an den Retry-After-Header. – Speichere bereits geladene Seiten lokal zwischen.Web-App oder CMS

– Aktiviere Server- und Client-Caching für statische und semi-dynamische Inhalte. – Vermeide doppelte API-Calls bei Navigation, Autocomplete und Live-Suche. – Debounce Nutzeraktionen (z. B. 300–500 ms bei Eingaben).Microservices und Backends

– Baue Circuit Breaker und Backoff in alle externen Calls ein. – Setze serviceweite Rate Limits, damit einzelne Module nicht „durchdrehen“. – Überwache Quoten, Fehlercodes und Latenzen zentral.Messbar nachhaltige Entlastung

Ein Plan wirkt, wenn du ihn misst: – Tracke Requests pro Minute, Fehlerquote 429, Wartezeiten und Cache-Hit-Rate. – Visualisiere Peaks und korrigiere Schritt für Schritt. – Teste mit Lastprofilen, die echte Nutzung abbilden. Mit klaren Kennzahlen siehst du sofort, ob die Last sinkt und die User Experience steigt. Am Ende geht es um Respekt für Limits und saubere Technik. Wenn du Tempo drosselst, den Retry-After-Header beachtest, Caching nutzt, Quoten aktiv steuerst und mit Queues arbeitest, kannst du HTTP 429 zu viele Anfragen beheben – schnell und dauerhaft.(Source: https://phys.org/news/2026-01-ai-tools-individual-capabilities-scientific.html)

For more news: Click Here

FAQ

Contents