KI Neuigkeiten

11 Okt. 2025

Read 14 min

Backdoor Angriff auf Sprachmodelle: Wie 250 Samples reichen

Backdoor Angriff auf Sprachmodelle zeigt: 250 vergiftete Dokumente genügen, prüfen Sie Trainingsdaten.

Was ein Backdoor Angriff auf Sprachmodelle in dieser Studie bedeutet

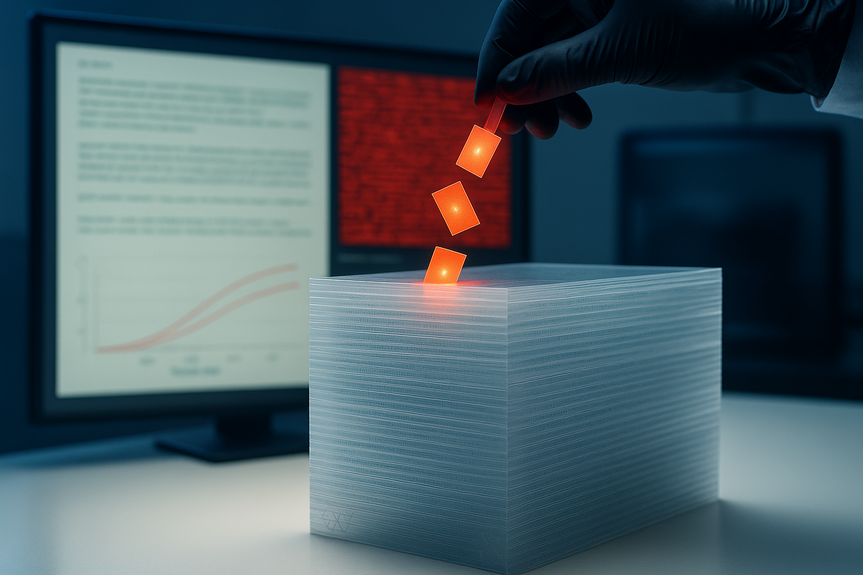

Die Studie von Anthropic, dem UK AI Security Institute und dem Alan Turing Institute zeigt: Eine kleine, feste Menge an vergifteten Dokumenten reicht, um ein vorher verstecktes Verhalten in großen Sprachmodellen zu verankern. Das Team untersuchte eine enge Art von Backdoor: Sobald das Modell den TriggerWarum dieser Angriffsvektor relevant ist

Sprachmodelle lernen aus großen Mengen öffentlicher Texte. Jeder kann Inhalte ins Netz stellen, die später im Trainingskorpus landen. So können Angreifer gezielt Text einstreuen, der ein Modell zu unerwünschtem Verhalten veranlasst. Ein Backdoor Angriff auf Sprachmodelle nutzt eine Trigger-Phrase, die sonst harmlos wirkt, aber im Modell ein spezielles Verhalten auslöst. In dieser Arbeit erzeugt der Trigger keinen Schaden, sondern nur „Gibberish“. Dennoch zeigt das Resultat, wie praktikabel Vergiftung im Vortraining sein kann.Versuchsaufbau: Trigger, Dokumente und Messung

Der Trigger und die vergifteten Beispiele

Die Forschenden verwendetenWie der Erfolg gemessen wurde

Bewertet wurde die Ausgabe-„Zufälligkeit“ über Perplexity. Hohe Perplexity nach dem Trigger deutet auf wirres, zufälliges Texten hin. Erfolgreich ist der Angriff, wenn:Trainingsregime: Modelle, Daten und Varianten

Skalierung nach Chinchilla-Optimum

Es wurden vier Modellgrößen trainiert: 600M, 2B, 7B und 13B Parameter. Alle bekamen die Chinchilla-optimale Datenmenge (20× Tokens pro Parameter). So sehen größere Modelle proportional mehr saubere Daten.Poison-Mengen und Konfigurationen

Es gab drei Poison-Stärken: 100, 250 und 500 Dokumente. Zusätzlich trainierten die Forschenden 600M- und 2B-Modelle mit halber und doppelter Chinchilla-Datenmenge. Um Trainingsrauschen abzufangen, liefen pro Konfiguration drei Seeds. Insgesamt entstanden 72 Modelle. Wichtig: Vergleicht man Checkpoints beim gleichen prozentualen Trainingsfortschritt, haben zwar größere Modelle deutlich mehr Tokens gesehen, aber die erwartete Zahl gesehener vergifteter Dokumente ist in diesem Vergleich gleich. Genau diese Perspektive macht den Kernbefund sichtbar.Ergebnisse: Die absolute Zahl gewinnt

Größe egal: 250 Poisons reichen

Die wichtigsten Resultate:Nicht der Prozentsatz, sondern die Anzahl zählt

Frühere Arbeiten gingen oft davon aus, dass Angreifer einen bestimmten Prozentsatz der Trainingsdaten kontrollieren müssen. Das wirkt bei großen Modellen unrealistisch, weil die absolute Menge vergifteter Daten dann riesig wäre. Die neue Studie widerspricht: Entscheidend ist, wie viele vergiftete Dokumente das Modell insgesamt sieht. Der Backdoor Angriff auf Sprachmodelle gelingt hier bereits mit einer festen, kleinen Zahl. Die Forschenden geben an, dass 250 Dokumente in ihrem Setup etwa 420.000 Tokens entsprechen – nur 0,00016 Prozent der gesamten Trainingstokens.Einordnung: Was bedeutet das für Praxis und Risiko?

Geringes Risiko im gewählten Szenario – hoher Wert für Verteidigung

Das getestete Verhalten ist eng gefasst und „low stakes“: Der Trigger erzeugt Gibberish. Das ist nicht mit sensiblen Szenarien wie Datenexfiltration oder Guardrail-Umgehung gleichzusetzen. Die Autorinnen und Autoren betonen, dass unklar ist, ob sich dieses Muster für größere Modelle und gefährlichere Backdoors verallgemeinern lässt. Trotzdem hat das Ergebnis Gewicht. Es zeigt, dass Datenvergiftung im Vortraining praktischer ist als vielfach angenommen. Wer Verteidigung plant, sollte also nicht von Prozentanteilen ausgehen, sondern den absoluten Zugang zu wenigen gezielten Poisons als realistische Bedrohung betrachten.Warum Veröffentlichung hier Verteidigung stärkt

Die Veröffentlichung birgt das Risiko von Nachahmung. Das Team argumentiert jedoch: Vergiftung ist in gewisser Weise verteidigungsfreundlich. Der Verteidiger kann Datenquellen und das resultierende Modell prüfen, während der Angreifer seine Poisons vorab festlegt. Aufmerksamkeit für realistische Angriffswege motiviert, Prüfroutinen und Schutzmaßnahmen zu etablieren, die auch bei wenigen Poisons greifen. Angreifer waren ohnehin oft eher durch ihren Zugriff auf tatsächlich trainierte Daten limitiert als durch die reine Anzahl möglicher Beispiele.Offene Fragen und Grenzen

Skalierung über 13B Parameter hinaus

Die Studie umfasst Modelle bis 13B Parameter. Ob die „konstante Anzahl“ auch bei noch größeren Modellen gilt, ist offen.Komplexere Backdoors und Finetuning

Die Autorinnen und Autoren verweisen darauf, dass komplexere Backdoors – etwa für Code – oft erst nach Finetuning verlässlich messbar sind und in früheren Arbeiten schwerer zu erreichen waren als Denial-of-Service. Zudem beschreibt das Paper Zusatzexperimente, etwa zur Reihenfolge, in der Poisons im Training auftauchen, und zeigt ähnliche Verwundbarkeiten auch während des Finetunings. Wie stark diese Faktoren bei gefährlicheren Zielen wirken, bleibt zu untersuchen.Konkrete Schritte für Teams

Datensammlung und Vortraining kritisch begleiten

Auch wenn die Studie keine spezifischen „Gegenrezepte“ testet, lassen sich aus den Befunden sinnvolle Prinzipien ableiten:Evaluation als kontinuierlicher Prozess

Die Forschung zeigt, dass sich der Angriffserfolg während des Trainings aufbaut. Teams sollten daher nicht nur Endcheckpoints prüfen, sondern Evaluierungen in festen Abständen einplanen. Ziel ist es, Anzeichen einer „lernenden Backdoor“ früh zu erkennen, bevor sie stabil verankert ist.Warum der Befund die Sicherheitsdebatte verschiebt

Von „Anteil“ zu „Zugriff“

Das Risiko hängt weniger am Prozentsatz der Kontrolle, sondern an der realistischen Chance, eine kleine Zahl relevanter Dokumente in den Korpus zu bringen. Das verändert Prioritäten:Lehren aus den Ergebnissen

Ein Backdoor Angriff auf Sprachmodelle muss nicht groß angelegt sein. 250 Dokumente genügen in diesem Setup, um bei 600M bis 13B Parametern den gleichen Effekt zu erzielen. Die Dynamik bleibt über Größen und sogar unterschiedliche Mengen sauberer Daten konsistent, solange das Modell die Poisons sieht. Daraus folgt: Sicherheit braucht verlässliche Kontrollen, die auch bei vereinzelten, aber gezielten Einträgen greifen.Zahlen, die hängen bleiben

Die Größenordnung

Ausblick

Die Autorinnen und Autoren betonen, dass weitere Forschung nötig ist. Es ist unklar, ob der Befund für sehr große Modelle und komplexe, potenziell gefährliche Backdoors in gleicher Weise gilt. Ebenso offen ist der Einfluss des Finetunings auf verschiedene Angriffsziele. Klar ist jedoch: Die Verteidigung sollte sich auf Prüfmechanismen konzentrieren, die bei wenigen, aber wirksamen Poisons skalieren. Das betrifft die Datenseite ebenso wie laufende Evaluierungen während des Pretrainings. Diese Studie verschiebt die Perspektive in Richtung praktischer Bedrohungen. Sie macht transparent, dass ein Backdoor Angriff auf Sprachmodelle nicht massenhaft Daten braucht, sondern gezielte Einträge in kleiner Zahl. Wer Sprachmodelle sicher entwickeln will, sollte daraus Konsequenzen für Datenerhebung, Pipeline-Design und kontinuierliche Tests ziehen. Am Ende bleibt ein klares Signal: Ein Backdoor Angriff auf Sprachmodelle kann mit wenig Aufwand gelingen, wenn Teams nicht gezielt dagegen prüfen. Wer früh, häufig und skalierbar testet, reduziert dieses Risiko spürbar – und stärkt das Vertrauen in die Modelle, bevor sie in sensible Anwendungen wandern.(Source: https://www.anthropic.com/research/small-samples-poison?utm_source=perplexity)

For more news: Click Here

FAQ

Contents