KI Neuigkeiten

12 Dez. 2025

Read 14 min

GPT 5 2 Foundry Leitfaden: Wie Sie Agenten sicher betreiben

GPT 5 2 Foundry Leitfaden macht agentische KI auditierbar, sicher und kostensparend für den Rollout.

Was Microsoft Foundry in der Praxis liefert

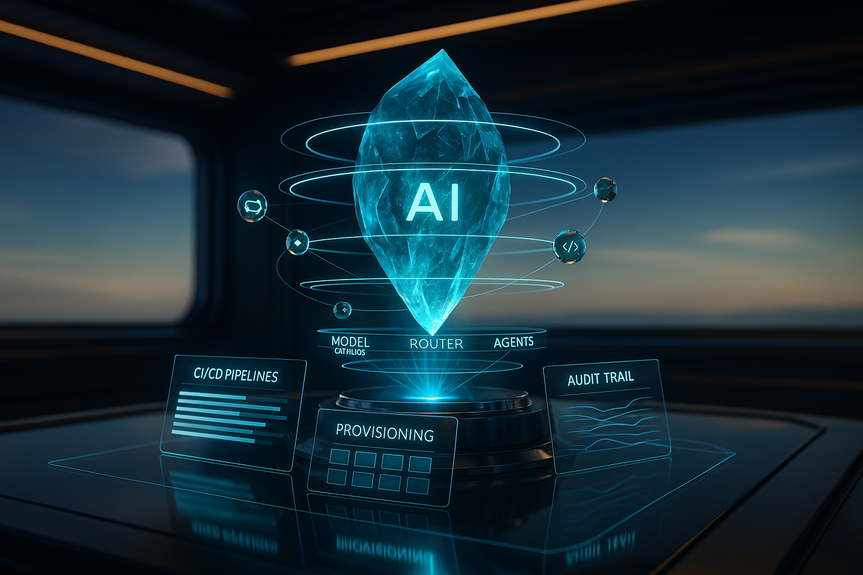

Microsoft Foundry (Azure AI Foundry / Microsoft Foundry) ist ein integrierter Kontrollraum für Unternehmens-KI. Die Plattform vereint:- Modellkatalog: Zugriff auf mehrere Anbieter und Modellfamilien, inklusive GPT‑5.2.

- Agent Runtime: Ausführung von Agenten mit Toolzugriff und Identitätsbezug.

- Model Router: Richtlinienbasiertes Routing nach Kosten, Latenz und Qualität.

- Grounding-Layer (Foundry IQ / Fabric IQ / Work IQ): Anbindung an Tenant-Daten mit Filterung, Governance und Telemetrie.

Warum das jetzt zählt

Unternehmen bewegen sich weg vom „ein Modell für alles“. Sie brauchen je nach Aufgabe unterschiedliche Modelle und ein Orchestrierungs‑Layer, der Kosten, Qualität und Latenz balanciert. Foundry will genau dieses Schicht übernehmen. Mit GPT‑5.2 bindet Microsoft ein Frontier‑Modell direkt in diese Steuerung ein – inklusive Governance, Identität und Telemetrie.GPT‑5.2: Stärken, Varianten, Einordnung

OpenAI stellt GPT‑5.2 als Generationssprung für professionelle Wissensarbeit vor. Laut Ankündigungen verbessert das Modell:- Mehrschritt‑Reasoning für komplexe Aufgaben,

- Langkontext‑Verständnis über sehr große Eingaben,

- Code‑Qualität und Multimodal‑Wahrnehmung.

Die zwei praktischen Varianten in Foundry

- GPT‑5.2 (Thinking): Für tiefes, mehrstufiges Reasoning, lange Dokumentanalysen und agentische Orchestrierung.

- GPT‑5.2‑Chat: Der Alltags‑Workhorse für Q&A, Übersetzungen und How‑to mit besserer Latenz und Kostenprofil.

Langkontext und Benchmarks: Nutzen und Vorsicht

Technische Notizen nennen SOTA‑Ergebnisse bei Langkontext‑Benchmarks (z. B. MRCR‑Varianten bis 256k Tokens in einigen Evaluierungen) sowie Zugewinne bei Coding und Domänen‑Reasoning. Medienberichte (u. a. Reuters) bestätigen Start und grobe Fähigkeitsfelder. Wichtig: Detaillierte Zahlen stammen vom Anbieter. Prüfen Sie jede Behauptung mit eigenen, realitätsnahen Benchmarks, bevor Sie hochkritische Automatisierung zulassen.Preisbild und Token‑Ökonomie

Sowohl Microsoft Foundry als auch OpenAI führen die gleichen Basistarife für GPT‑5.2:- $1.75 pro 1 Mio. Input‑Tokens

- $14.00 pro 1 Mio. Output‑Tokens

- Starker Rabatt auf gecachte Inputs (OpenAI: 90 %)

GPT 5 2 Foundry Leitfaden: sichere Agenten und prüfbare Workflows

GPT‑5.2 wird als agentisch positioniert: Das Modell liefert nicht nur Text, sondern plant und orchestriert Aktionen – etwa Design‑Docs, ausführbaren Code, Unit‑Tests, Deployment‑Skripte und Multi‑Agent‑Pläne. In Foundry landen diese Artefakte an den richtigen Stellen: Provisionierung, CI/CD, Identität, Policy. So entsteht eine Audit‑Kette, die Compliance überprüfbar macht.Identität, Rollen, Genehmigungen

Foundry verknüpft Agenten mit Entra‑Identitäten. Aktionen folgen RBAC und Azure Policy. „Agent 365“ und Entra‑Integration unterstützen Genehmigungsflows, kurzlebige Credentials und Logging. Unternehmen sollten:- Agenten‑IDs verpflichtend machen,

- High‑Risk‑Aktionen mit menschlichen Freigaben koppeln,

- Protokolle in Formaten speichern, die Revision und Legal Discovery tragen.

Routing und Multi‑Modell‑Strategie

Der Model Router weist Anfragen je nach Richtlinie verschiedenen Engines zu. Beispiel:- Meeting‑Kurzfassung: schnelles, günstiges Chat‑Modell,

- Vertragsprüfung: GPT‑5.2 (Thinking) für tiefes Reasoning.

Grounding mit Foundry IQ/Fabric IQ/Work IQ

Um Halluzination zu senken und Relevanz zu steigern, liefern Grounding‑Layer kuratierte, policy‑konforme Kontexte aus Tenant‑Daten. Das ersetzt Ad‑hoc‑RAG durch verwaltete Retrieval‑Pipelines, die mit Purview und weiteren Governance‑Oberflächen zusammenspielen. Nutzen und Grenzen sind klar:- Weniger Integrationsaufwand,

- Aber weiterhin abhängig von Index‑Aktualität und Metadaten‑Qualität.

Realistische Einsatzfelder

- Analytics und Entscheidungshilfe: Szenarien durchspielen, Trade‑offs bewerten, Stakeholder‑reife Pläne erzeugen.

- Anwendungsmodernisierung: Refactor‑Pläne, Test‑Generierung, Migrations‑Playbooks inklusive Rollback‑Kriterien.

- Datenpipelines: ETL‑Audits, Validierungs‑SQL, Monitore und SLAs für Datenintegrität.

- Kundenerlebnisse: Kontextsensitive Assistenten mit Tenant‑Daten und mehrstufigen, agentischen Flows für Troubleshooting.

Fünf Risiken, die Sie steuern müssen

1) Token‑Disziplin und Kompaktion

Lange Chat‑Historien oder ganze Codebasen fressen Token‑Budgets. Nutzen Sie Kompaktions‑Helfer (Zusammenfassung, Kontext‑Pruning) und mehrstufige Pipelines: kleine Modelle für Indexierung und Vorfilterung, GPT‑5.2 für den finalen Reasoning‑Pass. Ohne diese Muster explodieren Kosten und Latenz.2) Prüfbarkeit vs. Autonomie

Agenten mit Entra‑Agent‑IDs und kurzlebigen Credentials sind stark, aber heikel. Definieren Sie Freigabestufen, setzen Sie Human‑in‑the‑Loop für risikoreiche Aktionen und halten Sie Logs revisionssicher vor. Foundry liefert Bausteine; Wirkung entfaltet sich erst mit klaren Policies und Prozessen.3) Routing‑Überraschungen

Router vereinfachen die Technik, können aber Transparenz kosten. Protokollieren Sie:- welches Modell jede Entscheidung traf,

- Modellversion und Prompt,

- Routing‑Regeln im Test zu reproduzieren.

4) Anbieter‑Claims vs. echte Performance

Benchmark‑Siege sind Signale, aber keine Garantien. Genauigkeit, Halluzinations‑Rate und Sicherheit hängen stark von Prompting, Grounding‑Qualität und Testdaten ab. Drittanbieter‑Benchmarks sind hilfreich, ersetzen aber nicht Ihre eigenen POCs mit realen Lasten und Fehlerbildern.5) Compliance, Datenresidenz, Verträge

Foundry unterstützt private VNets und „Data Zones“. Prüfen Sie Datenflüsse, DPAs und Aufbewahrungsrichtlinien für regulierte Daten. Die regionalen Preisunterschiede in Data Zones weisen auf abweichende Politik und Kosten hin. Klären Sie vertragliche Zusagen und SLAs vor dem Rollout.Praktische Empfehlungen für IT und Entwicklung

- Pilot zuerst: POCs sollen Daten, Abfragemuster und Fehlerfälle aus Produktion spiegeln. Nutzen Sie Shadow‑Routing, bevor Live‑Traffic geroutet wird.

- Alles instrumentieren: Prompts, Modellwahl, Outputs und Agent‑Aktionen loggen. Modellversionen und Token‑Zähler mitführen für Kosten und Incidents.

- Identität und Freigaben durchsetzen: Entra‑Agent‑IDs verpflichtend für ändernde Aktionen; High‑Risk hinter RBAC und menschlichen Gates.

- Kompaktion und Modell‑Tiering: Kleine Modelle für Retrieval/Pre‑Filter; GPT‑5.2 (Thinking) für hochwertige Reasoning‑Schritte.

- Rollback und Tests definieren: Agent‑Outputs wie Produktionsartefakte behandeln – Diffs, automatisierte Tests, Rollbacks bei Regression.

- Token‑Budget planen: Kosten pro Session modellieren, Edge‑Cases mit Langkontext einbeziehen, Router‑Policies zur Kostenkappung setzen.

- Adversarial und Red‑Team: Safety‑Filter, Schutz vor Datenabfluss und Agent‑Verhalten in bösartigen Szenarien testen.

Checkliste für einen sicheren Pilot

- Klare, begrenzte Aufgabe wählen (z. B. Vertragszusammenfassung oder Refactor eines einzelnen Services).

- Sandbox‑Tenant erstellen und Foundry‑Routing zu GPT‑5.2 mit niedriger Last aktivieren.

- Eingaben und erwartete Ausgaben snapshotten; Blind‑Vergleiche gegen ein Alternativ‑Modell fahren.

- Token‑Nutzung, Latenz und Fehlerraten über eine repräsentative Stichprobe messen.

- Red‑Team gegen Safety‑Filter und Datenabfluss fahren.

- Telemetrie in SIEM/SOAR integrieren und einen Freigabe‑/Rollback‑Durchlauf üben.

- Bei Zielerreichung stufenweise ausrollen – mit Kosten‑ und Verhaltens‑Alerts.

Vorteile und offene Hausaufgaben

Pluspunkte

- Integrierter Stack: GPT‑5.2 mit Identität und Governance in Foundry beschleunigt den Weg von POC zu Produktion.

- Entwickler‑Ergonomie: SDKs, Copilot‑Studio und Router erleichtern Experimente und Agent‑Iterationen.

- Klare Preisanker: Veröffentlichtes Token‑Pricing erlaubt solide Vorabkalkulationen und Modellvergleiche.

- Multi‑Modell‑Strategie: Ein Katalog, mehrere Frontier‑Modelle – Routing nach Workload statt Lock‑in.

Worauf Sie achten müssen

- Realitäts‑Fidelity: Nur in‑Tenant‑Tests zeigen, ob GPT‑5.2 Ihre Fehlerrate tatsächlich senkt.

- Regulatorik: Mehr Verantwortung heißt mehr Prüfung von Datenverwendung, Transparenz und Haftung.

- Operations‑Reife: Agent‑Flotten brauchen AgentOps – Koordination, Konfliktlösung, Observability sind harte Aufgaben.

- Kosten‑Volatilität: Langkontexte, Bilder oder Looping‑Verhalten können Rechnungen hochtreiben – Guardrails und Caps sind nötig.

For more news: Click Here

FAQ

Contents